Reboisement et lutte contre les crues

Au cours du XIXe siècle, les pays européens furent frappés par des crues exceptionnelles avec une fréquence telle que les autorités publiques s’interrogèrent sur les causes de ces catastrophes et les moyens de les prévenir.

En particulier, à au moins deux reprises au cours du XIXe siècle, l’Europe a connu des crues catastrophiques :

- les inondations de 1840 à 1843 ;

- les crues de 1856 à 1857.

Ces événements ont poussé les états européens à réagir. En Suisse, jusqu’au milieu du XIXe siècle, les communautés villageoises géraient de façon autonome leurs forêts. Dès 1803, on voit apparaître les premières lois cantonales, notamment dans le Valais. Dans les années 1850 à 1860, plusieurs hommes politiques et ingénieurs ont travaillé à ce que la Confédération prît en main la question du reboisement comme moyen de lutte contre les crues ; deux professeurs de la toute jeune ETHZ, Elias Landolt et Carl Culmann, remettent plusieurs rapports au Conseil fédéral, suggérant des pistes. Toutefois, dans la première constitution suisse de 1848, la Confédération n’avait aucune compétence en matière de police forestière, qui restait du domaine des cantons. Il faut attendre 1874 pour voir la révision de la constitution (article 24 relatif à la surveillance des eaux et des forêts de montagne) et la création d’un service fédéral forestier calqué sur le modèle des Grisons. En 1876, la première loi fédérale sur la police des forêts entre en vigueur. Elle prévoit l’interdiction des coupes et l’obligation du reboisement dans les forêts de protection. La loi de 1910 complète le cadre réglementaire en mettant en place des subventions fédérales, qui lancèrent une série de grand travaux de protection sur tout le territoire national.

Pendant environ trois décennies (1830 à 1860), l’État français a été tenaillé entre d’un côté les tenants de la politique du reboisement prônée par les administrations et de l’autre les élus locaux soucieux de donner satisfaction aux agriculteurs peu enclins à l’amputation de leur terrain. Les crues du début des années 1840 donnèrent l’impulsion à une réflexion plus approfondie sur les moyens de lutte, avec deux grandes options :

- la correction des rivières, avec par exemple l’endiguement des principaux cours d’eau ;

- le traitement des versants, avec principalement le reboisement des versants dénudés, l’interdiction du défrichement, et la limitation du pâturage.

En France, deux lois essentielles ont consacré la forêt comme moyen privilégié de lutte contre les crues :

La forêt ne devenait plus un outil de prévention, mais une technique curative. On ne parlait plus de reboisement, mais de « restauration des terrains en montagne », une expression qui a été figée à travers le nom de l’organisme qui est né à cette occasion. En Italie, la loi du 20 juin 1877 engagea l’état italien dans une politique active de protection des forêts, avec à la fois des limitations fortes des coupes forestières et des plans de reboisement. Toutefois, compte tenu des difficultés économiques et du développement industriel dans l’Italie réunifiée, la loi fut marginalement appliquée, ce qui eut pour conséquence, en particulier, un accroissement des surfaces déboisées (entre 1870 et 1920, la surface forestière diminua d’environ 15 %). En réaction, le gouvernement promulgua la loi du 2 juin 1910 dite Loi Luttazzi, qui a notamment institué la création d’un Corps royal des forêts regroupant plus de 3000 gardes forestiers.

La forêt comme moyen de prévention

La forêt a été vue dès le Moyen Âge comme une valeur économique, qu’il fallait non seulement préserver, mais développer (Buridant, 2002). Sous le ministère de Colbert en France à la fin du XVIIe siècle, le corps des Eaux et Forêts se voit ainsi considérablement renforcer. Il faut attendre le début du XIXe siècle pour voir un fort regain d’intérêt pour la forêt en Europe, un intérêt croissant qui s’est traduit en France par la création de l’école forestière de Nancy en 1824 et la promulgation du Code forestier en 1827. En Italie, la première école forestière fut créée en 1869 à Vallombrosa (Florence).

La doctrine sur le rôle de protection de la forêt a été élaborée dès le milieu du XIXe siècle, notamment en France avec la publication en 1840 de l’ouvrage d’Alexandre Surell, qui eut un retentissement considérable. Surell écrivait ainsi :

Lorsqu’on examine les terrains au milieu desquels sont jetés les torrents d’origine récente, on s’aperçoit qu’ils sont toujours dépouillés d’arbres et de toute espèce de végétation robuste. Lorsqu’on examine d’une autre part les revers dont les flancs ont été récemment déboisés, on les voit rongés par une infinité de torrents du troisième genre, qui n’ont pu évidemment se former que dans ces derniers temps. Voilà un double fait bien remarquable… On peut appeler en témoignage de ces remarques toute la population de ce pays. Il n’y a pas une commune où l’on n’entende raconter à des vieillards que sur tel coteau, aujourd’hui nu et dévoré par les eaux, ils ont vu se dresser autrefois de belles forêts, sans un seul torrent. Considérons donc cette influence comme une chose démontrée, et résumons-la dans les deux propositions suivantes :

- la présence d’une forêt sur sol empêche la formation des torrents ;

- le déboisement d’une forêt livre le sol en proie aux torrents

L’ingénieur des Eaux et Forêts Paul Mougin a analysé dans le détail le rôle de la forêt. Sa description du rôle de la forêt dans le cycle de l’eau est toujours d’actualité. Selon Mougin, la forêt a trois rôles majeurs :

- grâce au phénomène d’évapotranspiration, elle permet d’intercepter une partie des eaux de pluie ;

- elle exerce une résistance au ruissellement, ce qui permet d’étaler les crues et éviter des pics de crue ;

- elle permet de lutter contre l’érosion en maintenant le sol grâce au réseau de racines.

Il défendit la thèse selon laquelle la forêt avait un impact profond sur le climat à travers plusieurs processus :

- la montée des températures ;

- l’augmentation de la pression atmosphérique ;

- une fréquence accrue des orages ;

- une fonte des neiges plus rapide ;

- la modification du régime des eaux de surface et des cours d’eau.

À l’époque de Mougin, on ne parlait pas de réchauffement climatique. Mougin ignorait donc que la remontée des températures observée depuis la fin du petit âge glaciaire était liée à une modification globale du climat (éventuellement déjà avec une influence anthropique) et donc pour lui, il ne pouvait y avoir qu’une cause : le déboisement. Mougin affirme donc que

pendant toute la période où les forêts étaient détruites on constate une augmentation de la température moyenne annuelle. (…) le chanoine Vaullet, après 40 ans d’observations, signalait le même fait démontré par la comparaison des températures depuis le début du siècle. Parmi les causes de la modification du climat, il place au premier rang, le déboisement. » Il avança également en comparant le nombre de crues et le nombre d’hectares défrichés qu’il y avait un lien étroit entre déboisement et nombre de crue : « au XVIIIesiècle, la Leysse a eu huit crues dommageables et trente-huit crues au XIXe siècle ; les crues sont donc devenues 4,7 fois plus fréquentes. Or, en 1738, la forêt couvrait 5398 hectares, soit 53,2 % du bassin de réception ; en 1910, elle ne s’étend plus que sur 3945 hectares, c’est-à-dire qu’elle a perdu 26,9 % de son étendue.

Lutter contre les crues, c’est donc avant tout lutter contre le déboisement. La doctrine française jusqu’à la seconde guerre mondiale, doctrine en vigueur dans tous les pays alpins, a été de mettre en avant une politique intensive de reboisement. Une doctrine qui se résume en la phrase lapidaire de Surell, reprise par Prosper Demontzey :

« la forêt seule peut venir à bout des torrents. »

Causes du déboisement

Comme le déboisement était considéré être la cause des crues que connaissait l’Europe en cette fin de XIXe siècle, il fallait trouver un responsable de ce déboisement. Le coupable fut vite trouvé : c’est le paysan et le berger, dont l’incurie était la cause de tous les malheurs. Écoutons Surell à ce sujet :

Dans ce magnifique bassin, la nature avait tout prodigué. Les habitants ont joui aveuglément de ses faveurs ; ils se sont endormis au milieu de ses dons. Ingrats, ils ont porté inconsidérément la hache et le feu dans les forêts qui om- brageaient les montagnes escarpées, la source ignorée de leurs richesses. Bientôt ces pieds décharnés ont été ravagés par les eaux. Les torrents se sont gonflés… des terrains immenses ont été engravés… Bientôt Crévoux, Boscodon, Savines et tous les torrents auront anéanti ce beau bassin qui, naguère, pouvait être com- paré à tout ce que les plus riches contrées possèdent de plus fertile et de mieux cultivé (…) Tous les hommes qui ne sont pas aveuglés par l’ignorance, ou dont le cœur ne s’est pas desséché par l’égoïsme, expriment la pensée qu’il serait temps enfin d’arrêter les progrès toujours croissants d’une si effrayante dévastation. Ils gémissent sur les maux sans nombre causés par le déboisement des montagnes… Entendons les cris de détresse d’une population alarmée sur son avenir.

Envoyé par le gouvernement de la Révolution, l’ingénieur Lomet (1795) notait au cours d’un voyage à Barèges en 1794, que c’est le déboisement qui est à l’origine des catastrophes récentes

Autrefois, toutes les montagnes qui dominent Barèges étaient revêtues de bois de chêne jusque vis-à-vis de la vallée d’Escoubous. Des hommes actuellement vivants en ont vu les restes et les ont achevés… Les habitants des plateaux ont tout ravagé eux-mêmes, parce que ces pentes étant les premières découvertes par leur exposition et par la chute des avalanches, ils y ont de bonne heure un pâturage pour leurs moutons, et que, le jour où ils les y conduisent, ils oublient que pendant l’hiver ils ont frémi dans leurs habitations de la peur d’être emportés avec elle par ces neiges, dont ils provoquent obstinément la chute

La littérature des forestiers et des géographes livre un florilège de clichés. Le géographe Jean-Yves Puyo livre quelques morceaux croustillants : « Le pasteur n’a pas le sentiment des égards dus aux forêts », « le fond du caractère du montagnard est l’imprévoyance absolue, l’inertie systématique opposées à toute idée du progrès, à toute tentative

d’amélioration, l’esprit est encore plus malade que le sol. », « c’est à l’imprévoyance des habitants, bien plus qu’à la constitution géologique du sol, qu’il faut attribuer le rapide écroulement des monts. »

Il ne faut toutefois pas croire que ces avis caricaturaux résultaient d’une analyse sommaire des causes du déboisement. Paul Mougin a entrepris une œuvre gigantesque de collecte d’informations historiques, d’observations naturalistes, et de données scientifiques sur le problème. Dans sa monographie sur les torrents de Savoie, Mougin défendit l’idée que les Alpes étaient à l’époque romaine couvertes de forêts épaisses : « Que les Alpes aient jadis été plus boisées qu’aujourd’hui, tout le démontre, et d’abord, la légende et la tradition. ». Le déboisement a commencé être pratiqué massivement au Moyen-Âge. Il a d’abord été le fait des religieux, pour qui la déforestation était presque un acte de foi à une époque où les croyances païennes considéraient les forêts comme la demeure des divinités. Puis, les besoins en pâtures, bois de chauffage, bois de construction, mais aussi le gaspillage et les guerres ont pendant des siècles amené à la destruction de la forêt. La forte poussée démographique du XVIIIe siècle et XIXe siècle n’a fait qu’accroître la pression sur la forêt. Si, à la lumière des avancées de nos connaissances sur la protohistoire et l’histoire des populations alpines, il paraît exagéré de dire que les Alpes étaient couvertes d’épaisses forêts, il faut reconnaître que la forêt a connu une forte régression dans les Alpes entre le XVIe siècle et le XIXe siècle. Les études historiques sur les communautés villageoises comme l’étude sur Vallorcine menée par Gardelle témoignent des rapports étroits entre l’homme et la forêt. Si la forêt est perçue à la fois comme une richesse et une protection (contre les avalanches), cela n’a pas empêché qu’elle soit surexploitée en dépit des règlements communaux (coupe affouagère 19 , droit de pâture) et des édits/lois de l’administration. En 1860, le syndic de Vallorcine dressa un tableau très sombre de la forêt communale, qui représente les trois-quart des espaces boisés : « l’état des forêts communales et les délits multiples qui s’y commettent les menacent d’une destruction partielle et prochaine ».

Alternatives au reboisement

À la fin du XIXe siècle, le reboisement n’a pas été l’unique stratégie de lutte contre les crues. Les états se sont aussi lancés dans de gigantesques travaux de correction torrentielle et d’endiguement des rivières. Dans un premier temps, les ingénieurs se sont principalement intéressés aux grands ouvrages de génie civil tels que les digues le long des rivières et les bar- rages pour fixer les sédiments. Cependant, assez rapidement, les dommages substantiels causés aux ouvrages de protection torrentielle posaient le problème de la rentabilité économique des opérations. Dans le canton de Vaud, l’ingénieur Alexis Chessex écrivait

On a, pendant vingt ans, construit d’innombrables barrages qui devaient permettre de reboiser les ravins. Nos paysans voulaient s’y opposer; ils durent se résigner à payer d’énormes impôts pour solder ces travaux qu’ils savaient inutiles. Heureusement, la société des forestiers suisses s’est décidée il y a deux ans, à adresser à toutes les municipalités du pays une brochure dans laquelle elle déclare enfin que le principe des grands barrages est économiquement faux ; l’aveu est complet.

À la fin du XIXe siècle, les ingénieurs se sont donc orientés vers des ouvrages de plus petite taille en complément des opérations de révégétalisation : des seuils pour fixer le lit d’un torrent, les clayonnages 21 pour limiter l’érosion des berges, les banquettes pour réduire le ruissellement et l’érosion sur des flancs de montagne, et les galeries de dérivation.

Résistance au reboisement

Bien avant la mise en place des grandes lois de la fin du XIXe siècle, les autorités locales ont tenté de lutter contre la déforestation en promulguant des édits visant à limiter ou interdire l’exploitation du bois. La « mise à ban 22 » des forêts ayant une fonction de protection a été mise en œuvre dès le Moyen Âge. Les plus anciens édits (lettres de ban) créant des « forêts à ban » datent du xive siècle dans les cantons de Schwytz et d’Uri ; en 1397, la forêt (Bannwald) protégeant Andermatt fut mise en ban : « le profane qui oserait porter la hache sur celui-ci [la forêt d’Andermatt] serait puni de mort » (Rabusseau, 2007).

Au XIXesiècle, les forestiers se plaignaient que les populations locales étaient rétives. Mougin dénonçait l’incivisme des populations, la corruption, et le manque de gardes forestiers : « Malgré cela, combien de délits demeuraient impunis, à cause du nombre in- suffisant des préposés et de la trop grande étendue de leur triage. (…) Une multitude de délinquants mal surveillés ou pactisant avec les gardes avaient dilapidé les forêts communales. (…) Le nombre du personnel subalterne devrait donc être augmenté si l’on ne veut pas voir réduire à une simple fiction la surveillance et la protection des forêts ». Il faut dire que pendant plusieurs décennies, les gardes forestiers étaient assez complaisants car issus des vallées dont ils avaient la surveillance, ils connaissaient la pauvreté des gens. L’administration reprochait la connivence entre habitants et gardes. Ainsi, en 1868 à Vallorcine, le Conservateur des forêts se plaignait que « le garde de Vallorcine qui est de la commune, éloigné de ses chefs, s’abandonne à toutes les influences, et principalement à celles des autorités locales qui peuvent en abuser » et il obligea la commune à engager un garde extérieur à la vallée.

La mise en place des lois sur la forêt a entraîné une forte réaction des populations montagnardes, très pauvres. Si les vols de bois sont fréquents, c’est que c’est une condition de survie pour des populations extrêmement pauvres, ce que Gardelle résumait de la façon suivante : « l’administration, dont les ingénieurs se recrutent dans la haute bourgeoisie des plaines, ne peut pas comprendre ces Vallorcins si lointains qui ne survivent qu’en volant du bois pour faire leurs seilles, en raclant la litière 23 , en laissant échapper leurs chèvres à travers la forêt. » L’historien Jérôme Buridant concluait « sur ce plan, l’administration pratique une certaine forme de despotisme éclairé, en cherchant faire le bonheur des peuples contre leur gré » (Buridant, 2002). Quoique l’administration forestière minimisa la résistance vue tout au plus comme « l’expression d’intérêts personnels isolés 24 », la législation subit plusieurs infléchissements sous les coups de boutoir des élus locaux. La loi du 8 juin 1864 autorisa l’engazonnement comme alternative au reboisement, ce qui permettait de ré- introduire les activités pastorales. Dès 1876, le gouvernement tenta d’encourager la création de fruitières 25 et le développement de troupeaux bovins au lieu des moutons et chèvres, qui causaient plus de dommages aux forêts. En France, la loi de 1882 avec l’instauration du service RTM marque un changement de cap dans la politique nationale sans pour autant changer l’impopularité auprès des populations locales, une situation que Buridant (2002) résume ainsi :

pour les populations montagnardes, [la restauration des terrains en montagne] a été imposée par les gens de la plaine, d’abord et avant tout pour défendre les villes de piémont des inon- dations. Défaut de dialogue, incompréhension mutuelle, errements du législateur, manque de politiques d’accompagnement : sur ce plan, il faut avouer que le reboisement des montagnes est aussi un échec.

Avec l’exode rural qui débute à la fin du XIXe siècle et s’amplifie au XXe siècle, la pression sur la forêt diminue fortement. La vive opposition qui existait entre populations autochtones et administration s’apaisa fortement. La première guerre mondiale marqua également la fin de la grande ère de la restauration en montagne.

Critique de la doctrine forestière

Dans son étude sur l’effet du reboisement, le botaniste Félix Lenoble, farouche adversaire de Mougin, concluait :

D’ailleurs les travaux de reboisement et de correction de torrents ont-ils une efficacité bien sérieuse contre ces paroxysmes des forces naturelles en montagne ? C’est douteux. La grandeur des masses en mouvement, l’influence du relief et l’action de la pesanteur ont ici une prépondérance telle que les obstacles qui leur sont opposés artificiellement figurent de simples fétus. La prétention de l’homme de maîtriser ces phénomènes, formidables à l’égard de sa faiblesse, fait penser à celle d’une fourmi qui croirait en remuant quelques grain de sable consolider les ruines de la cathédrale de Reims.

Les géographes, plus particulièrement les géographes français, se sont montrés particulière- ment critiques. Aujourd’hui, les études hydrologiques n’ont pas permis de trancher le débat sur le rôle des forêts sur les crues, probablement car il n’y a pas de réponse universelle à cette problématique. S’il est avéré que les forêts ont une influence positive sur la genèse et la propagation des crues en diminuant et étalant le volume de crue, elles n’ont qu’un rôle faible lors des phénomènes extrêmes. En Suisse et en France, les crues d’août 2005 ont montré que les forêts n’avaient pas empêché la formation de crues torrentielles et inondations importantes et que, pis encore, elles avaient contribué à augmenter les dommages à cause des bois flottants. En outre, la comparaison entre des bassins- versants avec des couvertures végétales différentes ne montre pas systématique une efficacité plus grande de la forêt pour freiner le ruissellement des eaux de surface : c’est en général la perméabilité du sol qui est le facteur clé.

Il existe une controverse très vive entre hydrologues, forestiers, et décideurs politiques. Si certains scientifiques considèrent que la forêt joue un certain rôle dans la prévention des crues, la plupart pensent qu’il s’agit d’un rôle mineur, voire d’un mythe. Calder & Aylward résument ainsi la situation :

il y a un écart croissant entre la perception du public et les preuves scientifiques concernant les causes des crues, leurs impacts, et les bénéfices des mesures de prévention. Pour nous, cet écart résulte de l’intense promotion de certains types d’utilisation du sol et d’interventions techniques par des des groupes d’intérêt particulier en l’absence de toute diffusion de données scientifiques qui auraient pu permettre de développer une vue contraire. Pour nous, cet écart a pu aboutir non seulement à gaspiller des fonds de développement (jusqu’à 10 milliards de dollars par an) pour des objectifs irréalisables, mais également à blâmer de façon injustifiée des populations montagnardes de pratiques qui n’ont en général qu’un impact limité sur les crues à l’aval. (…) Ce que l’on peut reconnaître, avec certitude, c’est que des solutions de gestion simplistes et populistes telles que les programmes commerciaux de reforestation qui sont souvent mis en avant, ne peuvent pas offrir une solution générale et, dans la plupart des situations, ont un intérêt au mieux marginalement positif et, au pire, des impacts négatifs.

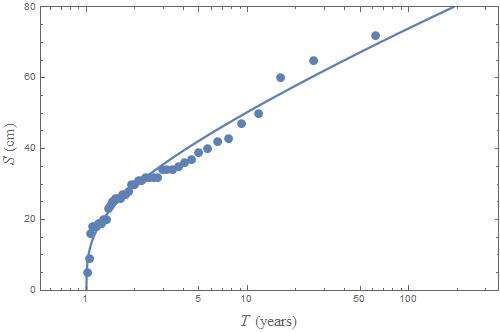

Figure 1 : variation de la neige tous les jours avec la période de retour à Chamonix (France) à une altitude de 1050 m. Les points représentent les chutes de neige mesurées (maxima annuels), tandis que la courbe continue montre la répartition de la loi des valeurs extrêmes ajustée sur les données.

Figure 1 : variation de la neige tous les jours avec la période de retour à Chamonix (France) à une altitude de 1050 m. Les points représentent les chutes de neige mesurées (maxima annuels), tandis que la courbe continue montre la répartition de la loi des valeurs extrêmes ajustée sur les données. Figure 2 : déclenchement d’une plaque sur tout le versant ouest de la Dent de Lys (Canton de Fribourg, Suisse).

Figure 2 : déclenchement d’une plaque sur tout le versant ouest de la Dent de Lys (Canton de Fribourg, Suisse).