Montroc, 20 ans après

Le 9 février 1999, il y a 20 ans, une avalanche partie de la montagne de Péclerey balaya le hameau de Montroc (Chamonix-Mont-Blanc, Haute-Savoie), tuant 12 personnes dans leur logement. Ce même hiver 1999, les avalanches touchèrent également des habitations en Suisse, Autriche, et Italie, et le nombre de victimes (68 personnes tuées dans des habitations) fut le plus élevé depuis 1970, année de la catastrophe de Val d’Isère. [1]

Février 1999 : tempêtes sur les Alpes

Depuis l’hiver 1999, les Alpes ont subi des passages dépressionnaires accompagnés de fortes chutes de neige, mais aucun ne présenta des cumuls de neige, des durées de précipitation, et un historique comparables à ce qui a été vécu en février 1999. À une époque où le réchauffement climatique fait surtout craindre le manque de neige, on pourrait y voir une fréquence moindre des épisodes neigeux critiques. Toutefois, si on examine la fréquence de tels épisodes au cours du XXe siècle (sans trop se focaliser sur le nombre de victimes, qui reflètent probablement plus l’intensification de la présence humaine que l’intensité des avalanches), on note qu’entre 1914 et 1950, il y a eu peu de gros épisodes critiques qui concernent une grande partie du massif alpin alors que pour la seconde moitié du XXe siècle, on dénombre plusieurs hivers critiques 1951, 1954, 1968, 1970, 1978, 1981, et 1999. De ce point de vue-là, nous sommes dans une phase plutôt calme. Cela ne présage rien quant à la tendance future.

Les réactions immédiates à la catastrophe

L’avalanche de Montroc a d’abord nourri la presse. L’analyse des articles parus dans la presse généraliste ou spécialisée montre que les journalistes ont surtout pointé la recherche du profit, l’urbanisation de secteurs à risque, et la complaisance des autorités locales face à la pression foncière. Cependant, les enquêtes diligentées par l’administration (le préfet de Haute-Savoie), puis la justice n’ont jamais fait ressortir d’éléments corroborant la thèse d’un urbanisme dévoyé par les intérêts privés à Montroc. Dès le lendemain de la catastrophe, le préfet de Haute-Savoie a commandé deux enquêtes : une diligentée par Richard Lambert (géographe de formation, consultant, universitaire, et expert près la Cour de cassation), et une autre conduite que j’ai présidée au Cemagref (en demande l’assistance de Météo-France). La justice mandata par la suite Richard Lambert pour l’expertise judiciaire. Les rapports d’expertise n’ont jamais été rendus officiellement publics, mais j’en ai tiré des articles parus dans des revues spécialisées pour ce qui concerne mon rapport [1].

Le maire, victime expiatoire ?

L’année 1999 a été une année noire pour la municipalité de Chamonix puisqu’en mai ce fut l’incendie du tunnel du Mont-Blanc qui endeuilla la commune. Responsable politique, le maire de Chamonix fut mis en examen et condamné, mais une loi d’amnistie annula cette condamnation. En gros, ce que la justice reprocha au maire, c’est de ne pas avoir fait évacuer les chalets de Montroc alors que la CLPA dans sa dernière version (1992) indiquait une avalanche allant jusqu’aux habitations. Dans ses attendus rendus en juillet 2003, le tribunal notait [2]

« Il était du devoir du maire, seul habilité à le faire, de prendre une mesure d’évacuation d’un site manifestement exposé à un risque majeur d’avalanche.

En s’en abstenant alors qu’il est démontré qu’il devait connaître le risque et qu’il avait les moyens de le faire, le maire a manqué à son obligation de prévenir l’avalanche par des précautions convenables et en cas de danger grave ou imminent, tel qu’en l’espèce, de prescrire l’exécution des mesures de sûreté exigées par les circonstances.

La faute ainsi commise par Monsieur Michel C. est établie, elle revêt un caractère d’une particulière gravité par l’accumulation des fautes d’appréciation du risque et de mise en œuvre de la prévention alors que de nombreuses vies humaines étaient en danger. »

Fronde des élus

La condamnation du maire de Chamonix n’a pas fait l’objet d’appel puisqu’il y a eu amnistie. Et donc le fond technique du dossier (la prévisibilité de l’avalanche, la possibilité d’évacuer des personnes pour une commune menacée par 116 couloirs d’avalanche) n’a pas été débattu plus longuement. Cela n’a pas été sans conséquence. Comme pour le jugement d’Évolène, les scientifiques (qui n’ont pas été auditionnés par le juge) sont moins catégoriques que la justice sur la connaissance certaine d’un risque fort. Les élus ont l’impression que l’État se donne le beau rôle en imposant le zonage de risque, tout en transférant la responsabilité opérationnelle aux autorités locales. Quand les services de l’État ont cherché à édicter des règles communes de zonage, ensemble de règles regroupées dans le « guide méthodologique PPR avalanche », ils ont cherché à promouvoir les zones jaunes, zones a priori soumises à un risque faible, mais qui exceptionnellement pourraient être touchées. Ces zones jaunes devraient compléter le découpage du territoire urbanisé (ou urbanisable) en rouge/bleu/blanc. Si des mesures constructives de protection paravalanche accompagnent les zones bleues, seules des mesures temporaires de consignation/évacuation concernent les zones jaunes. Cette évolution inspirée du modèle suisse aurait dû être facilement adoptée. Cela fût l’inverse. Techniquement prêt en 2002, le guide PPR avalanche élaboré par le RTM n’a été publié officiellement qu’en 2015 [7]. La fronde des élus chamoniards a bloqué le dossier pendant 13 ans. À ce jour, le hiatus entre juges, scientifiques, élus, et représentants de l’Etat sur un dossier comme celui de Montroc est toujours béant. Le temps a passé, la béance devient moins visible au fur et à mesure que le temps passe, mais elle est toujours là.

Réaction sur le long terme

Après le volet judiciaire, il y a une enquête administrative. Comme c’est souvent le cas le lendemain d’une catastrophe, on cherche des coupables, mais on cherche aussi comment éviter l’occurrence de nouvelles catastrophes. Il y a eu deux missions interministérielles commandées par l’État :

- En octobre 2000, la mission composée de B. Glass, P. Huet, M. Rat, et R. Tordjeman publiait son rapport sur l’avalanche de Montroc [3]. Parmi les préconisations, il y avait la révision du zonage de Chamonix, le guide PPR avalanche et un recensement des couloirs d’avalanches pouvant atteindre des zones habitées et des voies de communication (Sites Sensibles aux Avalanches) sur l’ensemble du territoire national. Le RTM se voyait confier l’élaboration du guide PPR et la révision du zonage tandis que le Cemagref (devenu Irstea) gérait le volet SSA.

- En avril 2011, Le Gallou et Guignard rendaient les conclusions de leur rapport sur les avalanches exceptionnelles [4]. Conclusions multiples avec des volets opérationnels et juridiques. Un point important a été de savoir comment prendre les bonnes décisions dans un environnement marqué par les incertitudes. Parmi les réponses esquissées, les rapporteurs préconisent le recours aux modèles numériques en dépit de leurs limites. Les rapporteurs relativisaient également la menace des avalanches par rapport à l’ensemble des risques que la France connaît.

Au fur et à mesure que le temps a passé, l’urgence a diminué, d’autres catastrophes naturelles comme la tempête Xynthia en 2010 ou les crues éclair à répétition sur la façade méditerranéenne ont focalisé l’attention des pouvoirs publics. Face au creusement du déficit, une constante de l’action publique a été de réduire les coûts en sabrant certains postes. Au cours des années 2010, l’ANENA a vu ses subventions étatiques et régionales fondre comme neige au soleil, le financement de l’enquête permanente des avalanches (EPA) et de la cartographie (CLPA) a été réduit, le RTM est passé du statut de service de l’État à prestataire commercial (établissement public à caractère industriel et commercial) sous la tutelle de l’ONF (organisme lui-même lourdement déficitaire). En dépit des déclarations publiques, les années post-Montroc marquent surtout un désengagement de l’État de ses missions régaliennes en matière de sécurité.

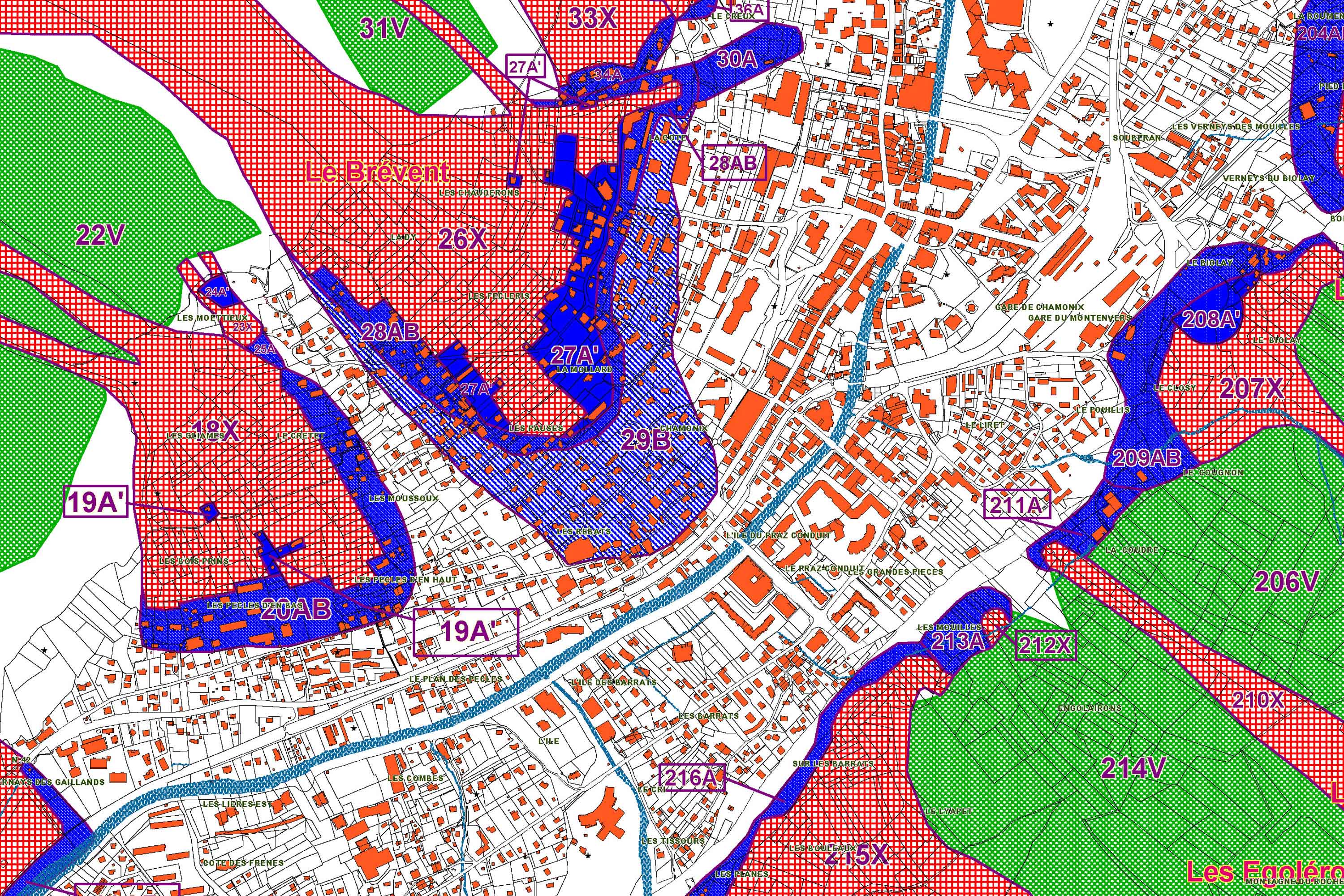

Révision du zonage

Une des conséquences de l’avalanche de Montroc (et des crues de 1996) a été aussi la révision du zonage de Chamonix. Le RTM a proposé une révision au début des années 2000, mais elle n’a pas convaincu tous les habitants. Une association de victimes (l’AIRAP) et des associations de riverains (Riverains du chemin du vieux four à Argentière) ont décidé de faire appel aux services de Richard Lambert. Il leur a rendu un premier rapport en 2007, mis en ligne sur le site de l’AIRAP. Ce rapport pointait des problèmes sur plus de 40 couloirs (donc le tiers des couloirs recensés sur la commune).

Cela a créé du remous, on l’imagine bien. En 2011, 4 ans après donc, la Direction générale de protection contre les risques du Ministère de l’environnement (DGPR), missionne M. Lambert qui rend son rapport sur le zonage PPR en janvier 2012. Embarrassée, la Direction départementale des territoires du territoire (DDT-74), désormais en charge du dossier, décide de lancer une consultation en avril 2012. Le cahier des charges prévoit le recours aux simulations numériques pour trancher le différend entre le zonage RTM et le zonage Lambert. C’était l’une des préconisations du rapport Le Gallou-Guignard. Contacté par la DDT-74, je leur indique que scientifiquement, aucun modèle n’est capable de répondre à la problématique (notamment, prédire avec la précision de l’échelle cadastrale l’extension de phénomènes exceptionnels). Pour la personne de la DDT en charge de cet appel d’offres, au diable les avertissements, peu importe l’état de l’art, on trouvera toujours quelqu’un pour faire le boulot quand il existe des codes commerciaux. En août 2012, la DDT confie l’analyse numérique de 50 couloirs à un groupement composé de Robert Bolognesi (géographe, Météorisk, Sion), André Burkard (ingénieur forestier, bureau Geoformer Brigue), Enrico Ceriani (technicien forestier, studio tecnico Ceriani, Aoste), et Jean-François Meffre (spécialiste des avalanches, ASI, Andorre). Si deux des membres sont des praticiens reconnus avec une grande expérience des avalanches et du zonage, aucun n’est un spécialiste de la dynamique des avalanches et de la simulation numérique. Il en est de même du comité de pilotage, sans aucun spécialiste. Le groupement a utilisé le code commercial Ramms vendu par le SLF. Comme ce sont les données du rapport Lambert qui ont été utilisées, il est peu étonnant que les simulations corroborent le dire d’expert de M. Lambert. Un membre de ce groupement me confiait que tout cela a dû être réalisé en peu de temps, avec la planification imposée par la DDT, ce qui a laissé peu de temps pour réellement mener une analyse fine, a fortiori quand le cahier des charges cadrait strictement la méthodologie de l’étude. Tout cela a quand même coûté 450 k€ à la collectivité. En mai 2015, la DDT présentait son nouveau zonage PPR. Dans un courrier à l’AIRAP, Richard Lambert qui avait porté l’essentiel du travail d’analyse regrettait que la DDT ne fasse pas mention à son travail, mais seulement à l’ « expertise internationale » (sic) [5-6]. Bref, il dénonçait l’ingratitude de la DDT 74. Hormis cette voix discordante, tout le monde s’est félicité du nouveau PPR, et personne n’a trouvé à redire face à la somme engloutie dans cet exercice en une période de disette budgétaire. Quelle a été la plus-value des simulations numériques hormis de donner un alibi scientifique ? Une question que la DDT a évité de se poser… ainsi que tous les responsables de l’État y compris à la DGPR à qui je l’ai posée.

Conclusions

Alors a-t-on progressé depuis Montroc en matière de zonage ? L’absence d’événements catastrophiques peut le laisser croire. La population croît, l’affluence touristique ne fléchit pas, la pression foncière va donc croissante, et cela pousse à construire dans des zones plus exposées aux dangers naturels. Pendant longtemps, le pragmatisme, le savoir-faire empirique et l’expérience ont été les outils de l’ingénieur ou du fonctionnaire pour évaluer au mieux le risque. Chez les praticiens expérimentés, je n’ai trouvé globalement que très peu d’erreurs dans les zonages, et celles-ci demeurent souvent dans la marge d’appréciation compte tenu des incertitudes (grandes) et de la fréquence (faible) des avalanches extrêmes. Ce qui apparaît comme le fait marquant des années 2010 est l’apparition d’une approche normative : des procédures encadrant les démarches de zonage, la traçabilité des changements, et le recours de plus en plus systématique à des modèles numériques. Cela peut sembler paradoxal, mais depuis lors, je n’ai jamais vu autant d’erreurs basiques dans le travail de zonage, et ces erreurs sont devenues très fréquentes. On a donné un vernis de technicité en généralisant les modèles numériques, mais plus grand monde, que cela soit dans les services instructeurs ou les bureaux d’étude, ne semble être capable de déceler les incohérences grossières qui peuvent apparaître dans les études. Face à un monde complexe, la tendance lourde de nos sociétés a été de créer des approches normatives. L’administration instruisant un dossier ne cherche plus à en vérifier la pertinence vis-à-vis du réel, mais la conformité par rapport à des critères qu’elle a elle-même établis. En parallèle des rapports officiels publiés par la DGPR, l’administration a produit une abondante littérature grise sur les avalanches, par copier-coller et compilation de sources variées façon wikipedia, auto-alimentant l’illusion d’un savoir scientifique et rigoureux. C’est très sérieusement que la DDT-74 annonce ainsi que pour le nouveau zonage « les études ont été poussées au maximum des outils actuellement disponibles » [6]. Cette déclaration hyperbolique n’est pas une ficelle de politicien (plus le mensonge est gros, plus il passe facilement) ou du positivisme à la mode de Coué, mais reflète bien l’incapacité de l’administration à distinguer le sérieux du loufoque dans les études.

Quand on dresse le bilan des deux dernières décennies, il ne semble guère que l’administration ait appris des erreurs commises dans le zonage avalanche. Les cafouillages ont été nombreux à Chamonix et expliquent le retard considérable dans la mise à jour du PPR (16 ans !) : surdité des services locaux de l’État, érosion des compétences au sein des services, fronde des élus, règlements de compte et querelles de clochers, et absence de toute expertise scientifique depuis le rapport de 1999. Les problèmes de fond ont été exacerbés et, escamotés sous le vernis d’une technicité affichée comme scientifique, ils sont des bombes à retardement. Dans le dossier de Chamonix, les choses ont bougé sous l’action des associations privées, et parce qu’un expert a fait l’essentiel du travail d’analyse critique. Mais ailleurs ? Il est fort probable que le prochain hiver à fort enneigement réserve de très mauvaises surprises.

Références

- [1] On peut se référer à cette page pour plus d’information : Avalanches de 1999. J’ai mis en ligne le rapport sur l’avalanche de Montroc que j’avais rédigé en 1999 à la demande de la Préfecture de Haute-Savoie.

- [2] Attendus du jugement de juillet 2003

- [3] Rapport Glass et col.

- [4] Rapport Le Gallou et Guignard

- [5] Nouveau PPR de Chamonix

- [6] Site de l’AIRAP et témoignage de Richard Lambert

- [7] Guide PPR avalanche

- [8] Rapport BBCM